Aplikacje AI mają dwie kluczowe cechy, które generują całe zamieszanie. Po pierwsze, są one zbudowane w oparciu o najnowsze technologie, które dopiero wkraczają na rynek. Po drugie, są w dużym stopniu zależne od interfejsów API. To powoduje, że w większości przypadków dostarczanie i bezpieczeństwo takich aplikacji nie jest znacząco inne od już istniejących. Te same usługi zabezpieczeń API mogą chronić API AI, a technologia opiera się na dobrze znanych protokołach, które można zabezpieczyć za pomocą ochrony przed DDoS (Distributed Denial of Service, rozproszona odmowa dostępu do usługi), jak i klasycznymi zaporami aplikacyjnymi – WAF (pomagają ochronić aplikacje sieciowe przed złowrogimi atakami i niechcianym ruchem sieciowym). Obawy o boty? Obrona przed botami również to obejmuje.

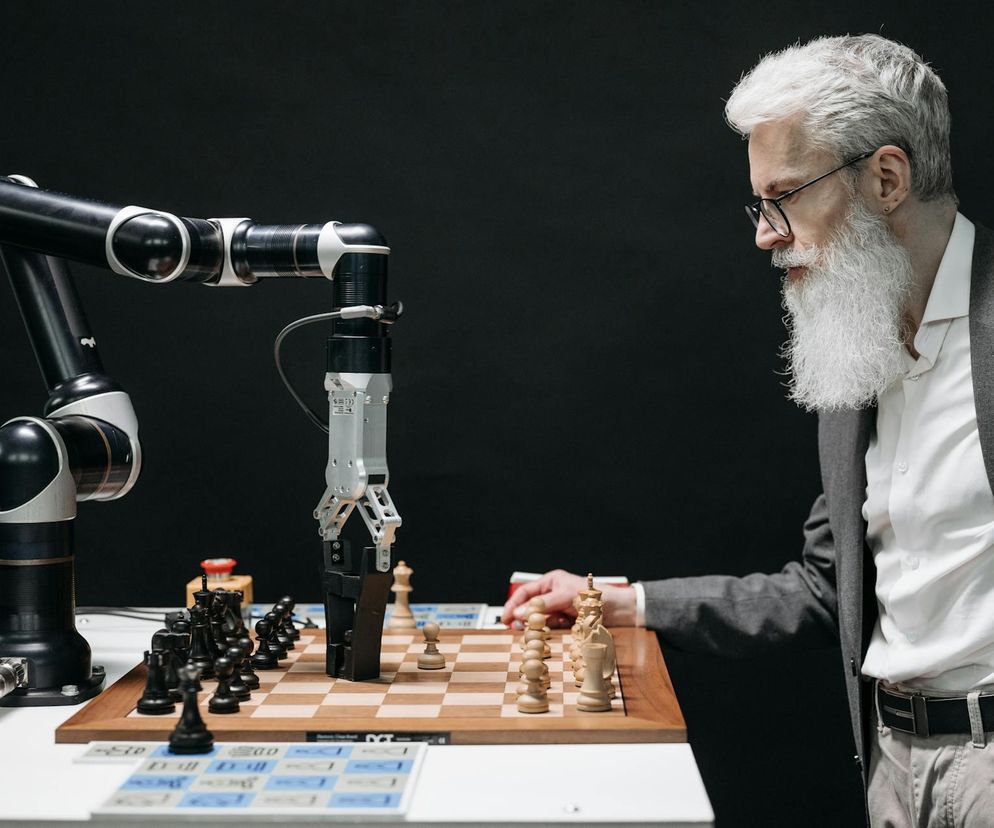

- Nasuwają się pytania. Czy są potrzebne nowe funkcje zabezpieczeń API? Tak, niektóre, szczególnie w kontekście pracy z danymi nieustrukturyzowanymi. Czy usługi dostarczania aplikacji, takie jak balansowanie obciążenia, muszą ewoluować, aby sprostać specyfice wnioskowania AI? Również tak, w pewnym stopniu. Ale same usługi pozostają w dużej mierze… takie same. Ale – i tutaj wkracza drugi „stan kwantowy” – wdrożenie aplikacji AI zazwyczaj oznacza zmianę architektury. Dlatego AI zmienia wszystko i nic jednocześnie – wyjaśnia Lori MacVittie, F5 Distinguished Engineer w F5.

Serwery wnioskowania AI to nie tylko serwery webowe czy aplikacyjne – stosują one wzorce architektoniczne, które rozszerzają nowoczesną architekturę aplikacji o nową warstwę poświęconą wnioskowaniu AI. Zmiany dotyczące komponentów i ich lokalizacji wpływają bardziej na dostarczanie aplikacji niż na ich bezpieczeństwo.

Przykładowo, analizując potencjalne miejsca w architekturze rozwiązania, które mogłyby posłużyć dla usług dostarczania i bezpieczeństwa aplikacji, widać, że głębsze warstwy architektury wymagają mniej tradycyjnych „usług wejściowych”, takich jak globalne balansowanie obciążenia, ochrona przed DDoS czy sieciowanie multicloud. Na „drzwiach wejściowych” niewiele się zmienia.

Warstwa wnioskowania będzie wymagała inteligentnego balansowania obciążenia. To właśnie kluczowy element dostarczania aplikacji. Dobrym pomysłem może być także AI gateway, który monitoruje i chroni wychodzący ruch AI, nie omijając również treści zapytań i odpowiedzi (tzw „warstwy L8” modelu ISO/OSI).

- Przeprowadziliśmy badanie rynku, które precyzyjnie określiło, jakiego rodzaju usługi chcą stosować użytkownicy i gdzie chcą je wdrażać. W przypadku dostarczania i bezpieczeństwa w punkcie wstawiania N-S AI, 44% badanych wskazuje na AI Gateway, 21% na zabezpieczenia API, 13% na balansowanie obciążenia, natomiast obronę przed botami wskazało 29%. Takie same usługi, choć w innych proporcjach, wskazano przy punktach wstawiania „N-S Front Door” – dodaje Lori MacVittie.W tym miejscu pojawia się zamieszanie. Zainteresowani rozumieją, że aplikacje AI to nowoczesne rozwiązania zależne od API. Dlatego obecne usługi dostarczania i bezpieczeństwa będą działały równie dobrze dla AI, jak dla innych nowoczesnych aplikacji i API. Jednocześnie klienci zdają sobie sprawę, że AI zmienia architekturę, wprowadzając nowe punkty wstawiania, gdzie te usługi mogą być lepiej wdrażane. To właśnie architektura jest największą zmianą wprowadzoną przez AI.

Nie jest to drobna kwestia. Zmiany architektoniczne wpływają na wszystko – od dostarczania i bezpieczeństwa aplikacji, po monitoring, automatyzację i sieciowanie. Oznacza to, że nawet jeśli usługi dostarczania aplikacji i bezpieczeństwa nie zmieniają się znacząco, to miejsce i sposób ich wdrażania – bardzo. Przyjęcie tego faktu jest ważną składową gotowości do skalowania sztucznej inteligencji w znaczący sposób.